Monitor Auflösung

Monitore wird in Zoll gemessen, schräg von der Seite (auf dem Bildschirm) Seite. Jedoch kann es ein großer Unterschied zwischen dieser Messung und dem tatsächlichen sichtbaren Bereich. Ein 14-Zoll-Monitor hat nur einen 13,2-Zoll-sichtbaren Bereich, ein 15-Zoll sieht nur 13,8 Zoll und 20 Zoll gibt Ihnen 18,8 Zoll (85,7% sieht mehr als ein 15-Zoll-Bildschirm).

Ein Computer-Monitor von Pixeln (kurz für „Bildelement“) gemacht. Monitor Auflösung in Pixel, Breite mal Höhe gemessen. 640 x 480 Auflösung bedeutet, dass der Bildschirm 640 Pixel breit und 480 hoch, ein Seitenverhältnis von 4: 3. Mit Ausnahme einer Kombination Auflösung (1280 x 1024 verwendet ein Verhältnis von 5: 4), werden alle Seitenverhältnisse gleich sind.

Vom PC Guide, von Charles M. Kozierok:

Ein Pixel ist das kleinste Element eines Videobildes, aber nicht das kleinste Element eines Bildschirms des Monitors. Da jedes Pixel aus drei getrennten Farben hergestellt werden müssen, gibt es kleinere rote, grüne und blaue Punkte auf dem Bildschirm, die das Bild bilden. Der Begriff Punkt wird verwendet, um diese kleinen Elemente zu beziehen, die das angezeigte Bild auf dem Bildschirm bilden. Um unterschiedliche Auflösungen auf einem Monitor zu verwenden, muss der Monitor der Lage sein, die automatische Änderung der Auflösung Modi zu unterstützen. Ursprünglich wurden Monitore an einer bestimmten Auflösung festgelegt, aber heute sind die meisten Monitore sind in der Lage, ihre angezeigte Auflösung unter Software-Steuerung zu ändern. Dies ermöglicht eine höhere oder niedrigere Auflösung in Abhängigkeit von den Anforderungen der Anwendung. Eine Anzeige mit höherer Auflösung zeigt mehr auf dem Bildschirm zu einer Zeit, und die maximale Auflösung, die der Monitor angezeigt werden kann, wird durch die Größe des Monitors und die Eigenschaften der CRT (Kathodenstrahlröhre) begrenzt. Darüber hinaus muss der Monitor ausreichend Eingangsbandbreite hat zum Auffrischen des Bildschirms zu ermöglichen, die bei höheren Auflösungen schwieriger wird, weil es so viel mehr Informationen an den Monitor gesendet werden.

Sie können unten, wie Bildschirmgröße und effektive Auflösung durch das Diagramm sehen verknüpft sind. Vergleichen einen 15-Zoll-Monitor und einen 21-Zoll-Monitor, beide auf 800 x 600 Pixel: Der 15-Zoll wird eine höhere Auflösung hat. Größere Monitore kleinere Pixel enthalten, um müssen die gleiche Auflösung zu erhalten, aber wenn ein kleiner Monitor auf eine hohe Auflösung eingestellt ist, würden die Bilder viel zu klein zum Lesen. Ein 14-Zoll-Monitor auf 640 x 480 eingestellt ist sehr gut lesbar, während ein 21-Zoll mindestens 1024 x 768. Hier muss einige empfohlene Auflösungen für die verschiedenen Bildschirmgrößen sind:

TheScreamOnline ist optimiert auf 1024 x 768 Auflösung für die Anzeige.

Wie Sie oben von der Chart sehen können, sollte es auf den meisten Monitoren gut aussehen.

Seien Sie sich bewusst, dass es viele Versionen und Interpretationen dieser Einstellungen sind.

Diese Tabelle ist ein Durchschnitt verschiedener Meinungen.

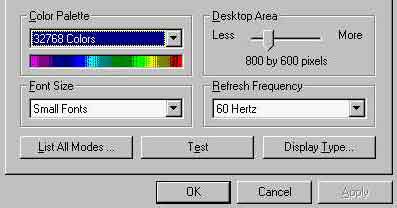

Auf einem PC mit Windows, gehen Sie wie folgt vor:

1. Doppelklicken Sie auf das Symbol Anzeige in der Systemsteuerung, indem Sie auf: Start> Einstellungen> Systemsteuerung.

2. Wählen Sie die Registerkarte „Einstellungen“ im Dialogfeld Anzeigeeigenschaften.

3. Stellen Sie den Schieberegler auf 800 x 600 (siehe unten), dann klicken Sie auf die Schaltfläche Test. Ein Test Bitmap wird für 5 Sekunden angezeigt, dann werden Sie gefragt, ob alles in Ordnung aussah. Klicken Sie auf Ja zu bestätigen.

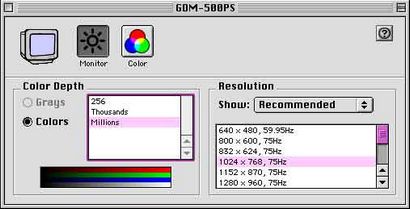

Auf einem Mac gehen Panels> Monitore zur Steuerung und Sie erhalten eine Liste der Einstellungen. Es könnte nicht einfacher sein.

Vom PC Guide, von Charles M. Kozierok

Es gibt 4 Standardfarbtiefen von Monitoren verwendet: 4-Bit (Standard VGA), 8-Bit (256-Farbmodus), 16-Bit (High Color) und 24 Bit (True Color). Jedes Pixel des Bildschirms Bild ist eine Kombination aus drei verschiedenen Farbsignale angezeigt werden: rot, grün und blau. Das Auftreten eines jeden Pixels wird durch die Intensität dieser drei Lichtstrahlen gesteuert. Wenn alle auf die höchste Stufe eingestellt sind, ist das Ergebnis weiß; wenn alle eingestellt sind die Pixel auf Null ist schwarz. Die Menge an Informationen, die zu einem Bildpunkt gespeichert wird bestimmt seine Farbtiefe, die steuert, wie genau die Farbe des Pixels festgelegt werden kann. Dies wird auch manchmal die Bit-Tiefe bezeichnet, da die Genauigkeit der Farbtiefe in Bits angegeben wird. Je mehr Bits, die pro Pixel verwendet werden, desto feiner ist die Farbe des Bildes ein. Aber auch höhere Farbtiefen erfordern deutlich mehr Speicher zur Speicherung des Bildes, und auch mehr Daten für die Grafikkarte zu verarbeiten, die die mögliche maximale Bildwiederholfrequenz reduziert.

256-Farbmodus. verwendet nur 8 Bits (2 Bits für Blau, für Grün 3, 3 für rot). Die Wahl zwischen nur 4 oder 8 verschiedenen Werten für jede Farbe würde in einem schlechten blocky Farbe führen, so ein anderer Ansatz statt genommen wird: die Verwendung einer Palette. Eine Palette wird erstellt, enthält 256 verschiedene Farben. Jeder ist definiert die Standard 3-Byte-Farbdefinition verwenden, die in der zutreffenden Farbe verwendet wird: 256 mögliche Intensitäten für Rot, Blau und Grün. Jedes Pixel wird erlaubt eine der 256 Farben in der Palette zu wählen, die eine „Farbzahl“ von Sorten in Betracht gezogen werden kann. So das gesamte Spektrum der Farbe kann in jedem Bild verwendet werden, aber jedes Bild nur 256 der zur Verfügung stehenden 16 Millionen verschiedener Farben verwenden kann. Wenn jedes Pixel angezeigt wird, sieht die Grafikkarte die echten RGB-Werte in der Palette auf der „Farbzahl“ die Pixel basierend auf zugeordnet ist.

256-Farben ist der Standard für viel von Computing, vor allem weil die höhere Präzision Farbmodi mehr Ressourcen (insbesondere Videospeicher) erforderlich und werden nicht von vielen PCs unterstützt. Trotz der Fähigkeit, die 256 Farben „Hand zu holen“, ist dieser Modus erzeugt merklich schlechte Bildqualität als hohe Farbe, und die meisten Menschen den Unterschied zwischen hohen Farb sagen können, und 256-Farben-Modus.

Hohe Farb. 16-Bit-Farbe # 151; verwendet zwei Informationsbytes, die Intensitätswerte für die drei Farben zu speichern. Dies wird durch das Brechen der 16 Bits in 5 Bits erfolgt für blau, 5 Bits für Rot und 6 Bits für grün, so dass 32 verschiedene Intensitäten für Blau, 32 für Rot, und 64 für Grün. Diese reduzierte Farbgenauigkeit führt zu einem leichten Verlust von sichtbaren Bildqualität, aber es ist tatsächlich sehr gering # 151; die meisten Menschen nicht, die Unterschiede zwischen echten und hohen Farb Bildern sehen können, wenn sie für sie sucht. es erfordert 33% (bzw. 50% in einigen Fällen) weniger Videospeicher, und es ist auch schneller aus dem gleichen Grund, aus diesem Grund ist eine hohe Farb oft statt der wahren Farbe # 151 verwendet.

Wahre Farbe. 24-Bit-Farbe # 151; drei Bytes Informationen werden verwendet, eine für jede der roten, blauen und grünen Signale, die jedes Pixel bilden. Da ein Byte 256 verschiedene Werte aufweist, kann jede Farbe 256 verschiedene Intensitäten hat, über 16 Millionen verschiedene Farbmöglichkeiten verwenden, und damit für eine sehr realistische Darstellung der Farbe der Bilder, ohne Kompromisse notwendig und keine Beschränkungen für die Anzahl der Farben einer Bild kann enthalten. In der Tat, 16 Millionen Farben sind mehr als das menschliche Auge wahrnehmen kann, obwohl wahre Farbe dafür qualitativ hochwertige Bildbearbeitung, Grafik-Design, etc. notwendig ist [Einige Grafikkarten haben für jedes Pixel 32 Bit Speicher zu verwenden, wenn Betrieb in True color, durch, wie sie den Videospeicher verwenden.]